jetson orin nano super AI模型部署之路(二)保姆级最好用AI环境配置

本文介绍在Jetson Orin Nano Super上配置AI Docker环境的方法,主要解决arm架构CPU和JetPack6.2版本兼容性问题。通过使用jetson-containers工具构建包含PyTorch和TensorRT等组件的镜像,并建议修改Docker默认运行时为nvidia。同时提供了调整Docker数据存储位置的建议,为AI模型部署提供了基础环境配置方案。

对于产品发布来说,最合适的环境配置方式是使用docker,产品和环境可以一起发布,用户会得到最好的使用体验。jetson orin nano super 的AI docker环境配置有两个难点:

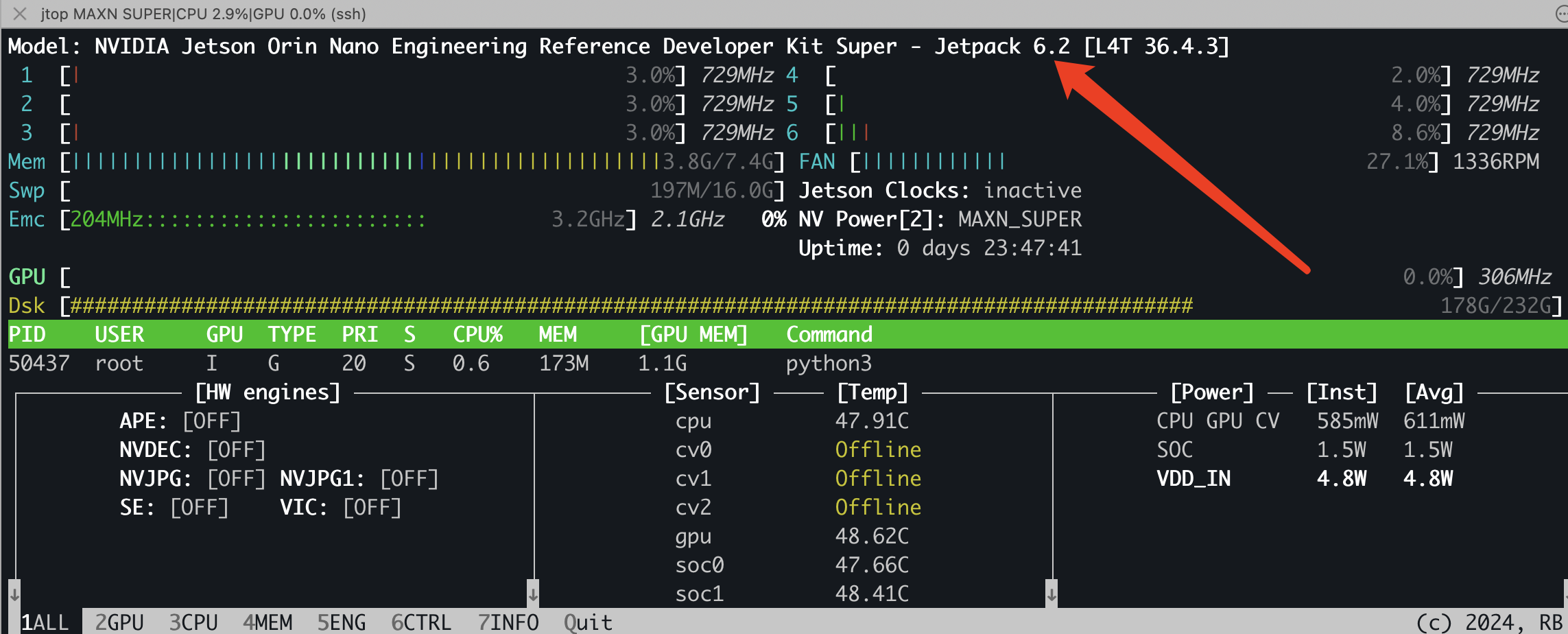

(1)CPU是arm架构 (2)super要使用jetpack 6.2[L4T 36.4.3]版本,因为版本太新,这个版本很多开源项目还没有发布对应的docker image,大部分的docker image都是基于jetpack 5.x构建的。

下面介绍一下我自己使用的包含pytorch和tensorrt(C++、python)等常用组件的docker image。

系统设置

check一下在jetosn orin nano super上安装的是JetPack 6。可以通过jtop工具来查看自己安装的jetpack版本。

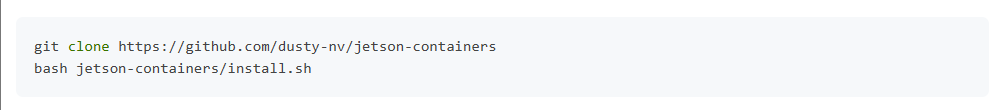

下载jetson-containers工具

jetson-containers可以通过模块化的方式来自动构建image,但是jetson-containers也有构建好的包含所有我们使用组件的image,我们用的就是他们构建好的image。

安装脚本会提示您输入sudo密码,并会安装一些Python依赖项,并通过在/usr/local/bin下建立链接的方式将诸如autotag之类的工具添加到$PATH中(如果您移动了jetson-containers存储库,请再次运行此步骤)。

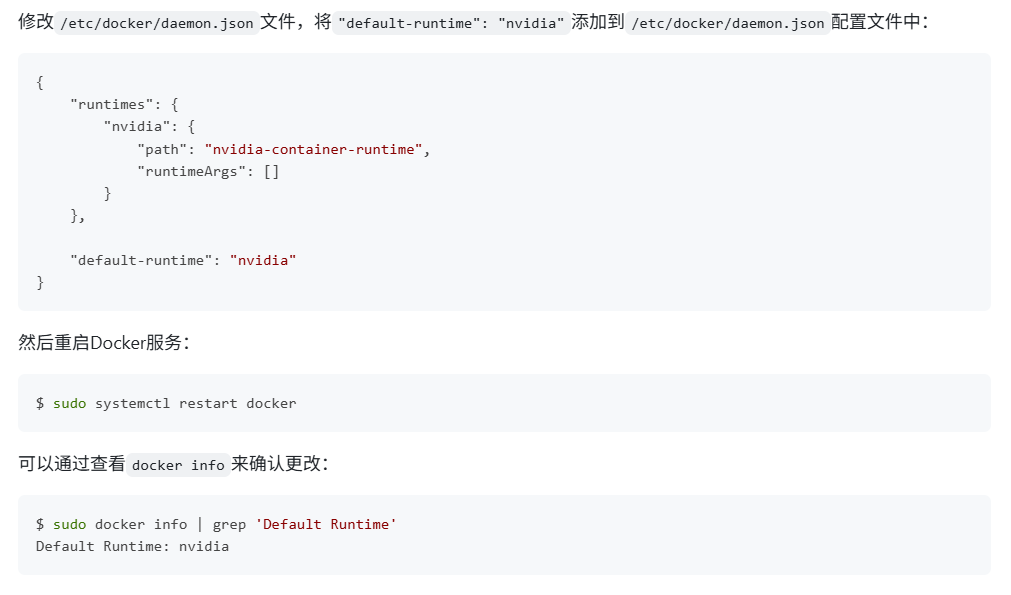

修改Docker默认运行时为nvidia

这一步建议做,不然每次启动container时,都要加上--runtime=nvidia,例如下面的启动指令,就要加上--runtime。

sudo docker run --runtime nvidia --gpus all --net host --ipc host -it --name pytorch_ngc_v2 -v /home:/home nvcr.io/nvidia/pytorch:25.01-py3-igpu

重新定位Docker数据根目录

这一步如果jetson设备已经额外安装了硬盘,就一般不需要做了。或者自己的docker安装位置分区足够,也不需要做。

容器可能会占用大量磁盘空间。如果有可用的外部存储,建议将Docker容器缓存重新定位到更大的驱动器上(如果可能的话,NVME是首选)。如果尚未格式化,请将驱动器格式化为ext4格式,并使其在启动时挂载(即应在/etc/fstab中)。如果在Docker守护进程启动之前,驱动器在启动时未自动挂载,那么Docker将无法使用该目录。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)