Dell PowerEdge-R720, Ubuntu24.04下Tesla P40上安装 nvidia-driver-535,并安装pytorch看是否能两卡使用

问大模型的话给出的回答是不建议这么装,但是最后是安装成功了,所以也不能太相信大模型的回答,最终还是要自己去尝试!接着安装pytorch。

·

问大模型的话给出的回答是不建议这么装,但是最后是安装成功了,所以也不能太相信大模型的回答,最终还是要自己去尝试!

# 1. 清理残留(可选)

sudo apt purge '^nvidia-.*' -y

sudo update-initramfs -u

# 2. 安装 535(Ubuntu 24.04 默认源中存在)

sudo apt update

sudo apt install -y nvidia-driver-535

# 3. 检查是否加载

lsmod | grep nvidia # → 空

dmesg | grep -i "nvidia\|p40"

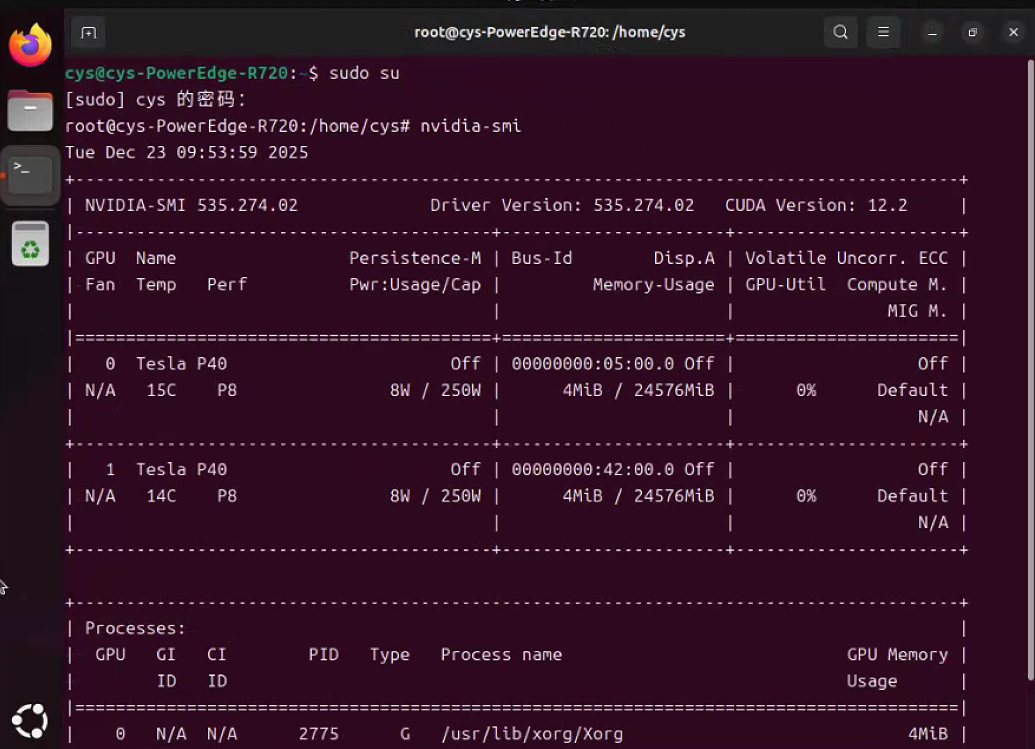

nvidia-smi

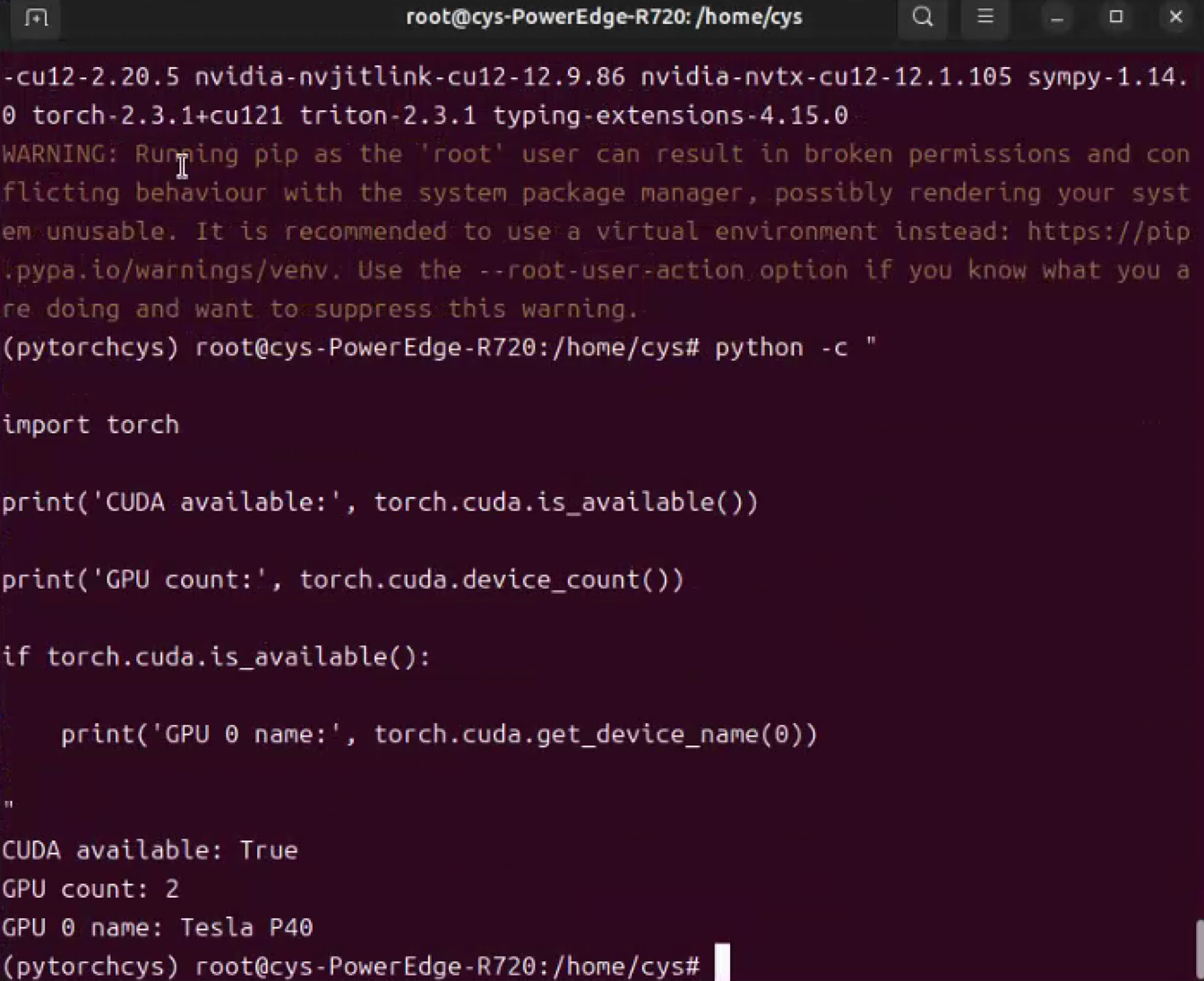

接着安装pytorch

pip install torch==2.3.1+cu121 torchvision==0.18.1+cu121 torchaudio==2.3.1 --extra-index-url https://download.pytorch.org/whl/cu121 python3 -c "import torch; print(torch.cuda.is_available(), torch.cuda.device_count())"

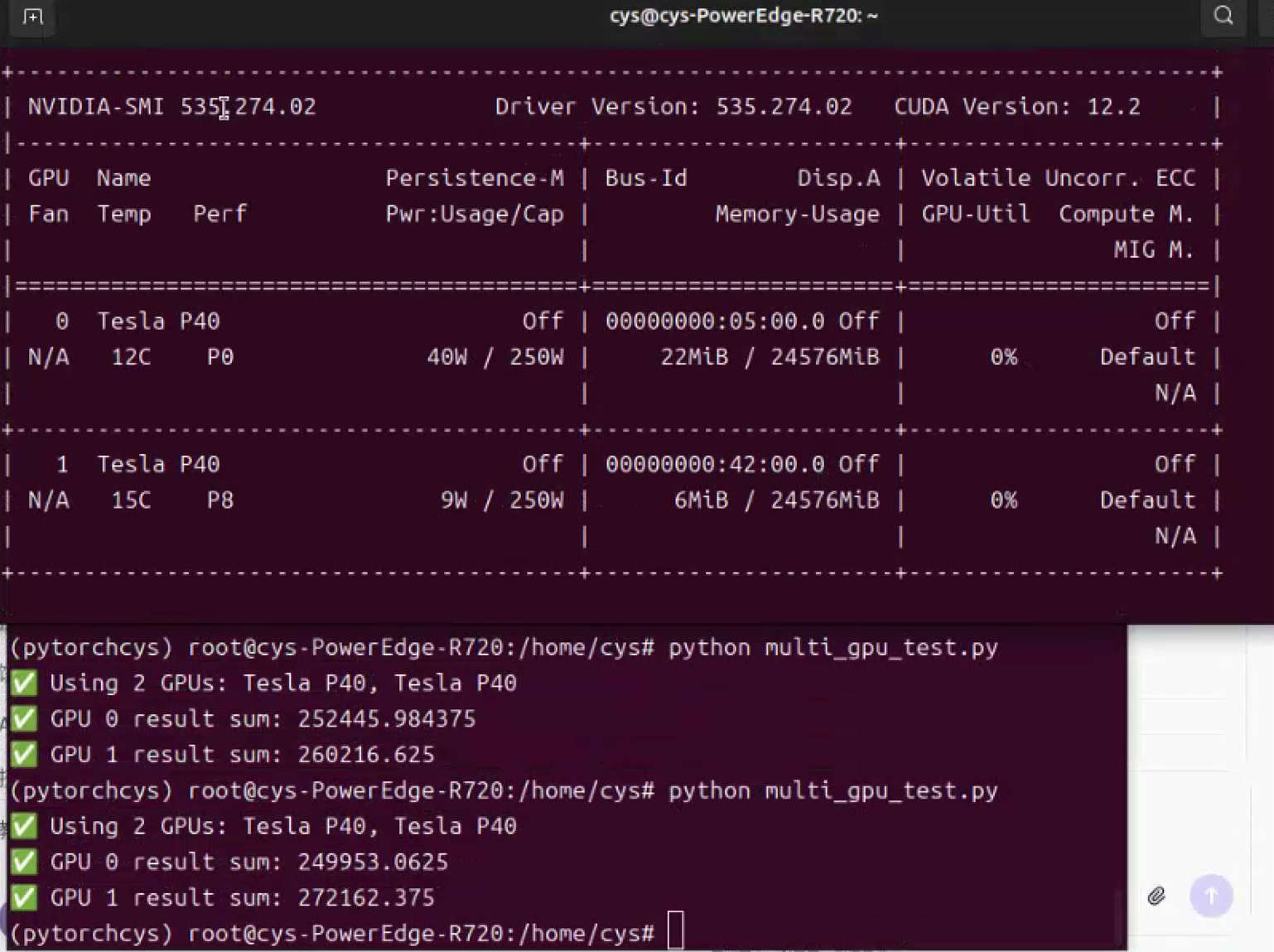

编写一个很简单的pytorch例子看看能否两卡调用到gpu资源:

多卡并行示例(利用你的 2 块 P40)

# multi_gpu_test.py

import torch

if torch.cuda.is_available() and torch.cuda.device_count() >= 2:

print(f"✅ Using {torch.cuda.device_count()} GPUs: {torch.cuda.get_device_name(0)}, {torch.cuda.get_device_name(1)}")

# 创建两个张量,分别放到不同 GPU

x0 = torch.randn(500, 500).cuda(0) # GPU 0

x1 = torch.randn(500, 500).cuda(1) # GPU 1

# 分别计算

y0 = torch.mm(x0, x0.T).sum()

y1 = torch.mm(x1, x1.T).sum()

print("✅ GPU 0 result sum:", y0.item())

print("✅ GPU 1 result sum:", y1.item())

else:

print("⚠️ Not enough GPUs — skipping multi-GPU test")

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)