通过Python和pandas高效读取XML数据

在现代数据交换和信息存储领域,XML(可扩展标记语言)是一种被广泛使用的技术。它允许开发者创建具有自描述性的数据,并以树状结构组织信息,从而方便各种应用之间的数据共享。pandas的起源可追溯至2008年,当时是为了解决金融数据分析中的时间序列问题而创建的。它是由Wes McKinney在AQR Capital Management工作时开始开发的。

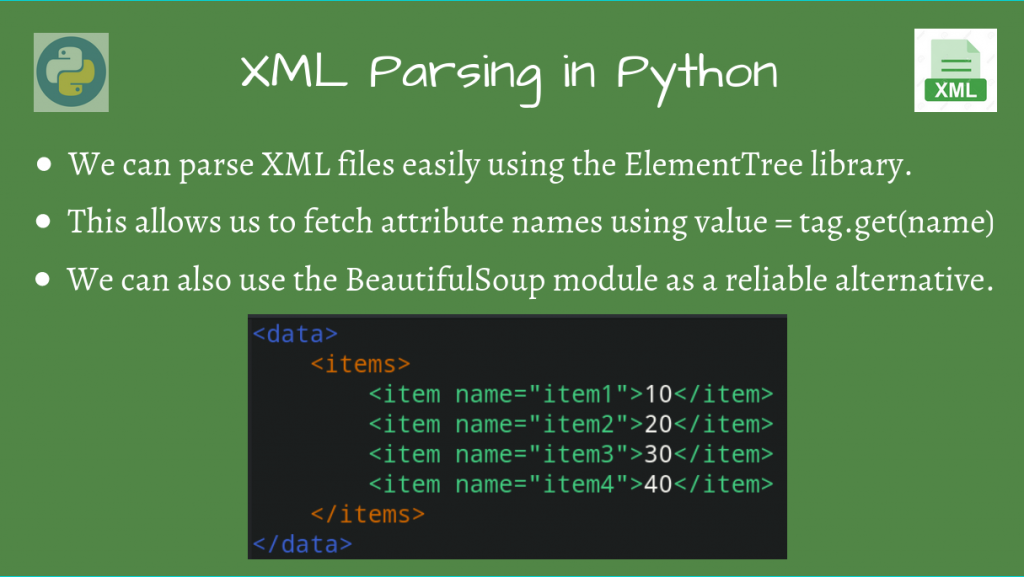

简介:XML是一种广泛用于数据存储和传输的格式,pandas作为Python中的数据分析工具,虽然本身不直接支持XML解析,但可以借助其他库如 xml.etree.ElementTree 来处理XML文件。本篇详细说明了如何使用Python中的pandas库以及 xml.etree.ElementTree 来读取和解析XML文件,最终将XML数据转换为DataFrame进行数据操作。文章还提供了详细的代码示例和步骤说明,帮助读者理解和应用这一过程。

1. XML文件基础介绍

在现代数据交换和信息存储领域,XML(可扩展标记语言)是一种被广泛使用的技术。它允许开发者创建具有自描述性的数据,并以树状结构组织信息,从而方便各种应用之间的数据共享。

XML的优势和应用场景

XML的优势在于它的灵活性和自我描述性,它能够让不同的系统之间无需事先约定就可以交换数据。XML文件是由一个根元素构成,并包含若干个子元素,每个元素都可以有自己的属性。在Web服务、配置文件以及文档存储中,XML扮演了至关重要的角色。

XML的结构和语法

XML文件的基本结构包括元素、属性、注释、文本以及指令。在语法上,XML要求正确使用标签,并且标签必须正确闭合。元素可以嵌套,但不能交叉。了解XML的这种结构对于数据处理尤为重要,尤其是在进行数据转换和解析时。

掌握XML的基础知识对于深入学习数据处理和信息管理是非常重要的一步。接下来,我们将探讨如何使用Python的 pandas 库来处理数据,以及如何将结构化的XML数据转化为更加灵活的 DataFrame 对象。

2. pandas库简介和功能

2.1 pandas库概述

2.1.1 pandas的起源和设计理念

pandas的起源可追溯至2008年,当时是为了解决金融数据分析中的时间序列问题而创建的。它是由Wes McKinney在AQR Capital Management工作时开始开发的。pandas的目标是成为Python中数据处理和分析的核心库,它提供了大量数据结构和操作工具,能够轻松处理结构化数据,并且与其它数据分析工具(如NumPy和Matplotlib)有着良好的集成性。

设计上,pandas重视灵活性、直观性和性能。灵活性意味着用户可以执行各种复杂的数据操作,直观性则让这些操作易于理解。性能方面,pandas对大型数据集进行了优化,可以高效执行数据操作,这在处理真实世界数据时尤为重要。

2.1.2 pandas的主要功能和用途

pandas的主要功能集中在数据结构(Series和DataFrame)上,可以进行如下操作:

- 数据导入和导出:从多种数据源导入数据,如CSV、Excel、JSON和SQL等,并可导出至相应格式。

- 数据清洗:包括缺失值处理、异常值检测、数据转换、归一化和标准化等。

- 数据合并与重塑:能处理多级索引、合并和连接数据集、重塑和透视表等。

- 时间序列分析:pandas在时间序列数据处理方面具有强大的功能。

- 数据统计分析:包括分组、聚合、描述性统计、交叉表等。

- 数据可视化:提供了内置的绘图工具,方便用户直接从数据结构绘制图表。

由于其强大的功能和易用性,pandas广泛用于金融分析、统计分析、学术研究以及工程和科学领域中。

2.2 pandas数据结构

2.2.1 Series对象的特点和操作

特点:

Series是pandas中一维的标签数组,能够保存任何数据类型(整数、字符串、浮点数、Python对象等)。其核心特性是能够持有一组数据和一组与之对应的索引。

操作:

- 创建Series对象:最简单的方式是从NumPy数组、Python列表或者字典创建。

import pandas as pd

# 使用NumPy数组创建Series

import numpy as np

series_from_array = pd.Series(np.arange(10))

# 使用Python列表创建Series

series_from_list = pd.Series([1, 2, 3, 4, 5])

# 使用字典创建Series

series_from_dict = pd.Series({'a': 1, 'b': 2, 'c': 3})

- 索引和访问数据:可以使用整数索引或者标签进行数据访问。

# 访问Series中的数据

print(series_from_list[0]) # 输出:1

print(series_from_dict['a']) # 输出:1

- 数据运算:pandas支持对Series进行向量化运算。

# 数学运算

print(series_from_list + 1) # 每个元素都加1

2.2.2 DataFrame对象的特点和操作

特点:

DataFrame是pandas中的二维标签数据结构,可以看作是Series对象的容器。DataFrame可以保存不同类型的列,并且每一列可以拥有不同的数据类型。

操作:

- 创建DataFrame对象:可以使用嵌套列表、字典或二维NumPy数组创建DataFrame。

# 使用嵌套列表创建DataFrame

data_list = [[1, 2, 3], [4, 5, 6]]

df_from_list = pd.DataFrame(data_list)

# 使用字典创建DataFrame

data_dict = {'a': [1, 2, 3], 'b': [4, 5, 6]}

df_from_dict = pd.DataFrame(data_dict)

- 索引和访问数据:可以使用列名或者位置索引访问数据。

# 访问DataFrame中的列

print(df_from_dict['a']) # 输出:0 1

# 1 2

# 2 3

Name: a, dtype: int64

- 数据操作:可以执行行切片、列选择、数据过滤等操作。

# 列选择

print(df_from_dict[['a']]) # 选择名为'a'的列

在pandas中,Series和DataFrame是两个核心的数据结构,它们是进行数据分析和处理时的基础。在下一章节中,我们将深入探讨如何使用 xml.etree.ElementTree 解析XML文件,并将其数据转换为pandas能够处理的格式。

3. 使用 xml.etree.ElementTree 解析XML

3.1 ElementTree解析器基本使用

3.1.1 ElementTree的安装和导入

ElementTree是Python标准库中用于解析和创建XML数据的模块。它提供了一个简单的API来处理XML,使得操作XML数据变得简洁高效。在使用之前,不需要特别安装ElementTree,因为从Python 2.5版本开始,它就已经被包含在Python标准库中。

要在Python脚本中使用ElementTree,需要导入xml.etree.ElementTree模块:

import xml.etree.ElementTree as ET

3.1.2 解析XML文件的基本流程

使用ElementTree解析XML文件的基本流程包括三个步骤:解析XML文档,遍历解析得到的树结构,以及对特定节点的处理。

- 解析XML文档 :可以使用

ET.parse()函数解析存储在文件中的XML文档,或者使用ET.fromstring()函数直接解析存储在字符串中的XML数据。

# 假设有一个XML文件'mydata.xml'

tree = ET.parse('mydata.xml')

- 获取根节点 :通过调用

getroot()方法可以获取XML文档的根节点。

root = tree.getroot()

- 遍历XML树结构 :接下来,可以遍历树结构中的元素进行进一步操作。例如,可以迭代根节点的子节点:

for child in root:

print(child.tag, child.attrib)

- 特定节点的处理 :如果需要对特定的节点进行操作,可以通过访问节点的子节点或使用XPath表达式定位特定节点。

# 使用XPath表达式查找特定节点

for elem in root.findall('path/to/element'):

print(elem.text)

以上是ElementTree解析XML的基本用法。通过这些步骤,可以轻松地从XML中提取所需的数据,并进行进一步的处理。

3.2 遍历XML树结构

3.2.1 访问XML节点的属性和文本

在解析XML后,通常需要访问节点的属性和文本内容。ElementTree中的每个节点(Element对象)都可以通过属性和方法来访问这些信息。

- 访问节点的属性 :每个节点都包含一个属性字典,可以通过

.attrib属性来访问这个字典。该字典包含了当前节点的所有属性以及对应的值。

# 访问节点的属性

for child in root:

print(child.attrib)

- 访问节点的文本内容 :节点对象的

.text属性包含了节点的文本内容。如果节点是元素的开始标签和结束标签之间的空白或换行,可以通过.tail属性访问这些内容。

# 访问节点的文本内容

for child in root:

print(child.text)

- 节点的完整文本内容 :如果需要获取节点及其所有子节点的完整文本内容,可以使用

.itertext()方法,它会遍历节点和所有子节点,并返回一个包含所有文本内容的迭代器。

# 获取节点及其所有子节点的文本内容

for text in root.itertext():

print(text)

3.2.2 根据节点名称和属性遍历节点

为了更精细地操作XML树,需要根据节点的名称和属性进行特定的遍历。

- 根据节点名称遍历 :使用

findall()方法可以找到所有匹配指定XPath表达式的节点。XPath表达式可以包含节点名称和其他条件。

# 根据节点名称查找特定节点

for elem in root.findall('name_of_the_element'):

print(elem.tag, elem.attrib)

- 根据属性遍历节点 :使用

findall()方法结合XPath表达式,可以基于节点的属性来查找节点。这允许根据特定属性值进行筛选。

# 根据属性查找特定节点

for elem in root.findall('.//[@attribute_name="value"]'):

print(elem.tag, elem.attrib)

通过这些方法,我们可以高效地遍历XML树结构,并访问到所需的节点数据。这样的操作对于数据提取和预处理阶段是非常重要的。

在继续深入探讨之前,让我们总结一下到现在为止所了解的内容。在本章节中,我们介绍了使用Python的 xml.etree.ElementTree 模块来解析XML文档的基础。我们已经了解到如何安装和导入ElementTree模块,以及如何解析XML文件并获取其根节点。还学习了如何遍历XML树结构,包括访问节点的属性和文本内容,以及如何根据节点的名称和属性进行有选择性的节点遍历。这些操作为提取XML数据以及进一步的数据处理提供了基础。在下一节,我们将更加深入地了解如何处理XML节点的数据,并探索如何将这些数据有效地转换为字典格式,以便于存储和分析。

4. 将XML数据转换为字典

4.1 XML转字典的方法

4.1.1 递归函数实现转换

在处理结构化的XML数据时,我们常常需要将这种层次结构转换为更易于处理的扁平化数据结构,如Python字典。一个常见的方法是编写一个递归函数,这个函数能够遍历XML树中的每一个节点,并将其转换为字典格式。

import xml.etree.ElementTree as ET

def xml_to_dict(element):

if len(element) == 0: # Base case: no child elements

return element.text

result = {}

for child in element:

child_dict = xml_to_dict(child)

if child.tag in result:

if not isinstance(result[child.tag], list):

result[child.tag] = [result[child.tag]]

result[child.tag].append(child_dict)

else:

result[child.tag] = child_dict

return {element.tag: result}

# 示例:将XML文件转换为字典

tree = ET.parse('example.xml')

root = tree.getroot()

# 转换XML根节点为字典

root_dict = xml_to_dict(root)

print(root_dict)

在这个函数中,我们首先检查元素是否没有子节点。如果没有,我们直接返回它的文本内容。如果有子节点,我们递归调用 xml_to_dict 来处理每个子节点。当遇到相同的标签时,我们将结果放入列表中,以处理可能的重复标签和层次结构。

4.1.2 利用栈和队列简化转换过程

递归方法虽直观,但在处理非常大的XML文件时可能会遇到栈溢出的风险。使用栈和队列可以提供一个非递归的替代方案,避免这种风险。

def xml_to_dict_iter(element):

stack = [(element.tag, {}, [element])]

result = {}

while stack:

key, node_dict, children = stack.pop()

if key not in node_dict:

node_dict[key] = children[0].text if len(children) == 1 and children[0].text is not None else None

else:

node_dict[key] = [node_dict[key]] if node_dict[key] is not None else []

node_dict[key].append(children[0].text if len(children) == 1 and children[0].text is not None else None)

for child in children:

if child:

stack.append((child.tag, {}, list(child)))

return result

# 示例:将XML文件转换为字典

tree = ET.parse('example.xml')

root = tree.getroot()

# 转换XML根节点为字典

root_dict = xml_to_dict_iter(root)

print(root_dict)

这个迭代版本的函数使用了一个栈来避免递归,通过显式地管理函数调用的历史记录,从而规避栈溢出的风险。它从根节点开始,将其标记和子元素压入栈中,然后遍历栈中的所有元素,根据它们的结构逐个更新字典。

4.2 字典数据的结构化处理

4.2.1 字典推导式在数据转换中的应用

字典推导式是Python中强大的功能之一,可以用来创建字典,并且在转换数据时可以大幅减少代码量。

def dict_comprehension_example(xml_root):

# 假设已有一个xml_root元素

return {child.tag: child.text for child in xml_root}

# 示例:使用字典推导式简化转换过程

tree = ET.parse('example.xml')

root = tree.getroot()

# 使用字典推导式将XML根节点转换为字典

root_dict_comp = dict_comprehension_example(root)

print(root_dict_comp)

字典推导式非常适用于简单的转换,可以将直接从XML元素生成字典的过程大幅简化,使得代码更加简洁。

4.2.2 处理嵌套和复杂结构的字典

当遇到嵌套结构时,简单的字典推导式可能就不够用了。在这种情况下,我们需要编写更复杂的逻辑来处理多层嵌套的字典结构。

def handle_nested_structure(xml_element):

result = {}

for child in xml_element:

if len(child) == 0 or len(child[0]) == 0:

result[child.tag] = child.text

else:

result[child.tag] = handle_nested_structure(child[0])

return result

# 示例:处理XML的复杂结构

tree = ET.parse('complex_example.xml')

root = tree.getroot()

# 处理复杂结构的字典转换

nested_dict = handle_nested_structure(root)

print(nested_dict)

这个函数通过检查元素是否包含子元素,并递归地处理这些子元素,以处理可能的嵌套结构。它创建一个字典,并递归地填充数据,直到达到最深层的叶子节点。

通过这些方法,我们可以有效地将XML数据转换为Python字典,从而为后续的数据处理和分析工作奠定基础。

5. 利用 pd.json_normalize 将字典序列化为DataFrame

在数据处理和分析领域,将数据从一种格式转换为另一种格式是非常常见且必要的过程。特别是在IT领域中,数据经常以复杂的嵌套结构存在,例如JSON或XML文件。Pandas库提供了强大的工具 json_normalize 来将嵌套的字典和列表结构转换成扁平化的 DataFrame 对象,这对于数据分析尤其重要。本章节将介绍 json_normalize 的用法及其背后的原理,以及如何将嵌套的字典数据转换为表格形式。

5.1 pandas中的json_normalize介绍

5.1.1 json_normalize的作用和优势

json_normalize 是pandas库中的一个函数,它专门用于处理嵌套的字典或列表数据,并将其展开成 DataFrame 结构。与传统的二维表格结构不同,嵌套的数据通常包含更复杂的数据结构,如多层嵌套的字典和列表,这使得数据转换变得困难。 json_normalize 提供了一种自动化的方式来处理这些数据,从而使得转换过程更加高效和简洁。

优势:

- 自动展开嵌套结构: json_normalize 可以自动识别嵌套的字典和列表,并将其转换为扁平化的表格形式。

- 处理嵌套列表:不仅处理嵌套的字典, json_normalize 还可以处理嵌套列表。

- 灵活的指定键:可以通过 record_path 参数指定需要展开的嵌套路径。

- 处理缺失值:自动处理在展开过程中可能产生的缺失值。

5.1.2 json_normalize的使用参数详解

json_normalize 拥有多个参数,以适应不同的数据结构和需求。以下是 json_normalize 的一些核心参数及其说明:

data: 要转换的嵌套字典或列表。record_path: 指定用于提取记录的嵌套路径。meta: 提取额外的元数据信息并将其作为额外的列添加到结果中。meta_prefix: 当使用meta参数时,指定前缀以避免与数据记录的列名冲突。record_prefix: 在提取的列名前添加前缀,以避免与原始字典中的键名冲突。errors: 参数指定如何处理缺失的记录或元数据路径。默认为抛出异常。

理解这些参数对于有效使用 json_normalize 至关重要,因为它们允许用户精确控制转换过程。

5.2 字典到DataFrame的转换过程

5.2.1 构造正确的字典输入格式

要使用 json_normalize ,首先需要构造一个嵌套的字典或列表结构。这个结构应该反映出你想要转换的数据的层级关系。例如,一个包含嵌套列表的字典可能如下所示:

data = {

"person": [

{"name": "Alice", "age": 25, "city": "New York"},

{"name": "Bob", "age": 30, "city": "San Francisco"},

],

"education": [

{"degree": "BSc", "year": 2010, "institution": "University A"},

{"degree": "MSc", "year": 2015, "institution": "University B"},

]

}

在这个例子中, person 和 education 字段包含了相关的嵌套数据。 json_normalize 可以被用来将这些嵌套数据展平成一个 DataFrame 。

5.2.2 处理多级索引和列表嵌套

在处理复杂的嵌套数据时, json_normalize 可以被用于处理嵌套的列表,并且可以创建多级索引以保持数据的层次结构。例如:

import pandas as pd

data = {

"person": [

{"name": "Alice", "age": 25, "city": "New York", "hobbies": ["reading", "cycling"]},

{"name": "Bob", "age": 30, "city": "San Francisco", "hobbies": ["traveling", "hiking"]}

]

}

# 使用json_normalize来展平嵌套的字典

df = pd.json_normalize(data, record_path="person", meta="person.hobbies")

print(df)

在这个例子中,我们不仅展开了 person 的字典,还使用 meta 参数将 hobbies 字段作为额外的列添加到了结果 DataFrame 中。这样,我们就能够获得一个包含所有必要信息的表格,同时保持了数据的层级和结构。

接下来,我们将深入探讨如何在不同的数据转换场景中使用 json_normalize ,以及如何处理一些特定的数据结构挑战。

6. 数据清洗和处理方法

在数据科学和分析中,数据清洗和处理是一个不可或缺的步骤,它确保数据质量,为后续的数据分析和建模工作打下坚实的基础。pandas库作为一个强大的数据处理工具,在处理缺失值、异常值以及数据选择和过滤等方面提供了极为方便的方法和技巧。

6.1 数据清洗的常见问题

数据清洗是数据预处理的关键部分,目的在于发现并修正数据集中的错误,提高数据质量。

6.1.1 缺失值的处理

缺失值是在数据集中通常以NaN(Not a Number)表示的空白或空缺数据。处理缺失值的方法包括删除含有缺失值的记录、填充缺失值以及使用插值方法。

- 删除记录:如果数据集较大且缺失值较少,可以考虑删除含有缺失值的记录。

- 填充缺失值:可以使用固定值、平均值、中位数或者使用模型预测缺失值。

- 插值:pandas提供了插值方法如

interpolate(),可以平滑地填充连续数据集中的缺失值。

import pandas as pd

# 假设df是一个DataFrame,存在缺失值

# 删除含有缺失值的记录

df_clean = df.dropna()

# 填充缺失值为列的平均值

df_filled = df.fillna(df.mean())

# 使用线性插值填充缺失值

df_interpolated = df.interpolate()

6.1.2 异常值的识别和处理

异常值是那些不符合预期模式的数据点,它们可能是错误或真实的罕见事件。异常值的处理包括识别和修正或删除。

- 箱形图识别:箱形图可以直观地识别数据中的异常值。

- 统计测试:使用Z-score或IQR(四分位距)等统计方法识别异常值。

- 删除或修正:如果确定某些值是异常值,可以选择删除这些记录或修正它们。

# 使用IQR识别异常值

Q1 = df.quantile(0.25)

Q3 = df.quantile(0.75)

IQR = Q3 - Q1

# 计算上下界

upper_bound = Q3 + 1.5 * IQR

lower_bound = Q1 - 1.5 * IQR

# 识别并删除异常值

df_filtered = df[(df >= lower_bound) & (df <= upper_bound)].dropna()

6.2 DataFrame的数据处理技巧

一旦数据被清洗,下一步就是进行数据选择、过滤、分组和聚合等操作。

6.2.1 数据选择和过滤

在pandas中,数据选择和过滤是通过索引和条件表达式实现的。这使得从大型数据集中提取感兴趣的信息变得非常容易。

# 选择单列数据

df['column_name']

# 使用条件表达式进行过滤

df[df['column_name'] > value]

# 同时满足多个条件

df[(df['column_name1'] > value1) & (df['column_name2'] < value2)]

6.2.2 数据分组和聚合

数据分组允许我们根据一个或多个列的值将数据分组,聚合函数则可以在每个分组上应用以得到统计摘要。

# 按照一列进行分组

grouped = df.groupby('column_name')

# 应用聚合函数计算均值

grouped_mean = grouped.mean()

# 应用多个聚合函数

grouped聚合 = grouped.agg(['mean', 'std', 'count'])

这些技术是pandas库中处理和分析数据的基础。熟练掌握它们将有助于有效地处理数据清洗、数据整理和数据提取的工作,为数据科学工作流奠定稳固的基础。

简介:XML是一种广泛用于数据存储和传输的格式,pandas作为Python中的数据分析工具,虽然本身不直接支持XML解析,但可以借助其他库如 xml.etree.ElementTree 来处理XML文件。本篇详细说明了如何使用Python中的pandas库以及 xml.etree.ElementTree 来读取和解析XML文件,最终将XML数据转换为DataFrame进行数据操作。文章还提供了详细的代码示例和步骤说明,帮助读者理解和应用这一过程。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)